人間と機械との音声による対話

人間は他人に何かを伝える時、音声を使って対話をします。もちろん、メールを使ったり絵を書いたりと、いろいろな手段を使うことはできますが、その場に相手がいる時に一番手軽でよく使われる手段は音声による対話でしょう。そのため、ロボットなどの機械に何かを伝える時にも音声による対話を使うことができれば便利です。それは、どのようにして実現できるのでしょうか。

人間が話した言葉を理解するためには、音声認識という技術を使って音声を文字に変換することが必要になります。その後意味を理解し、返答すべき内容を音声合成を使って声にします。こうした技術は古くから研究され、現在では実用の段階にはいりつつあります。スマートホン上で音声で問い合わせをすると答えてくれるアプリを使用した人もいるでしょう。しかしこうした技術だけでは、より自然な人間同士のような対話は実現できないのです。

音声による対話は思っているより難しい

例えば友達同士でどこに遊びにいくか相談している場面を想像してみてください。ある友人が「ボーリングに行こうか?」と提案しました。それに対して別の友人が「ボーリングかぁ」と答えました。さて、この友人はボーリングに行きたいのでしょうか、それとも行きたくないのでしょうか。

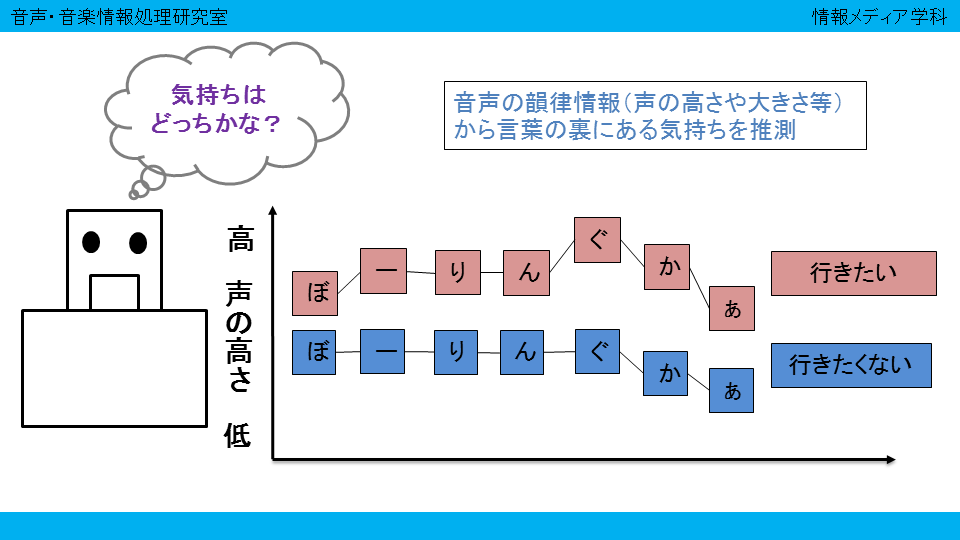

同じ「ボーリングかぁ」という言葉であっても、それが楽しそうに話されていれば「行きたい」、嫌そうに話されていれば「行きたくない」という意思表示になります。人間はこうした「言葉の裏にある相手の気持ち」を感じながら対話をします。しかし、音声認識では「ボーリングかぁ」という文字だけしか見ませんので、その裏にある気持ちを理解することはできません。話されている言葉を完璧に文字に変換できた(現実には、まだ完璧に変換することはできないのですが・・・)としても、それだけでは人間同士のような対話は実現できないのです。

音声に含まれる気持ちの理解を目指して

私達の研究室では、こうした「言葉の裏にある気持ち」を理解するための研究を行っています。同じ言葉であってもどのような口調で話されたのか、それはどのような気持ちを表しているのか。数多くの音声データを分析し、それらを統計的なモデルで表現することで「相手の気持ち」を発言内容だけではなく、口調といった情報もあわせて自動推定する方法を研究しています。

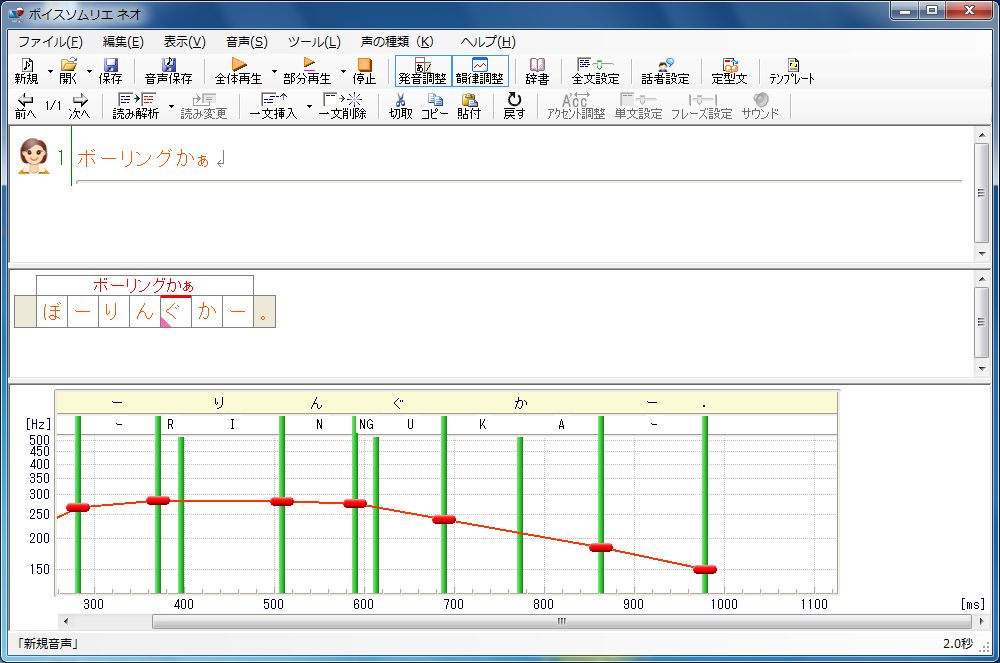

また、音声合成においても「ロボットの気持ち」を込めなければ自然な対話は実現できません。どのような音声にしたらうまく気持ちを込められるのか、そうした研究にも取り組んでいます。

ドラえもんは、2112年に製造されたとのことです。その頃までには、ドラえもんのような人の気持ちを推察できるロボットが実現できているといいですね。