マルチメディア応用研究室(平山研)の研究テーマは「マルチメディアコミュニケーションシステムに関する研究」です。IT技術を核にして、映像・画像・CG、音響・音声、感覚・運動などを複合的に使って、マルチメディアアプリケーションの開発と作品制作を行い、人の役に立つものを作って、社会貢献することを目的としています。映像機器・音響機器とコンピュータを組み合わせて様々な技術開発をしています。最近はスマホやタブレットの性能が向上してきているので、AndroidやiPhone/iPadのプログラミングをして、アプリ開発をすることも多いです。様々な技術開発を学生と一緒に行っていますが、そのうちのいくつかを紹介します。

視覚・聴覚支援技術

2006年国連総会で障害者権利条約が採択され、2014年には日本も条約を締結しました。その国内法整備の一環として2016年4月には障害者差別解消法が施行されています。障害者に対する合理的配慮を実現していくことが社会的な課題になっています。

私たちは、目が見えない人、耳が聞こえない人でも、快適な生活を実現するための様々な技術開発を行っていますが、今回は視覚障害者が映画を楽しむときの音声ガイドを骨伝導ヘッドフォンで聞く方法について紹介します。視覚障害者でも映画を観に行くの?と思われる方もいるかもしれませんが、視覚障害者でも映画を観に行くし、家庭でテレビやDVDも楽しんでいます。

でも、見えないとわからない部分も多くあるため、セリフがない時間やセリフとセリフの間に説明音声が入る映画音声ガイドという仕組みを使っています。映画館でバリアフリー上映と表記してある上映は、視覚障害者用音声ガイドが利用可能です。微弱FM電波で音声ガイドを送信し、ラジオで受信し、ヘッドフォンで聞くシステムが一般的です。ところが、この方法だと最新の多チャンネル臨場感音響を備えた劇場に行っても、音声ガイドを聞くためにヘッドフォンで耳を塞いでしまうため、せっかくの臨場感音響を楽しめないことがありました。そこで、耳を塞がなくても聞くことのできる骨伝導ヘッドフォンを利用して音声ガイドを聞き、耳では映画館の臨場感音響を聞いてもらう方法を考えました。このような音声ガイド視聴システムを組み、視覚障害者の方の意見も聞きながら、実証実験と改良を進めてきて、視覚障害者の方にも好評です。

博物館展示技術

マルチメディア技術を応用した博物館展示技術についても研究開発を進めています。2015年に国立民族学博物館で「韓日食博」という特別展があったのですが、そのとき大阪工業大学情報科学部がプロジェクションマッピングやバーチャルリアリティを使った展示で協力しました。

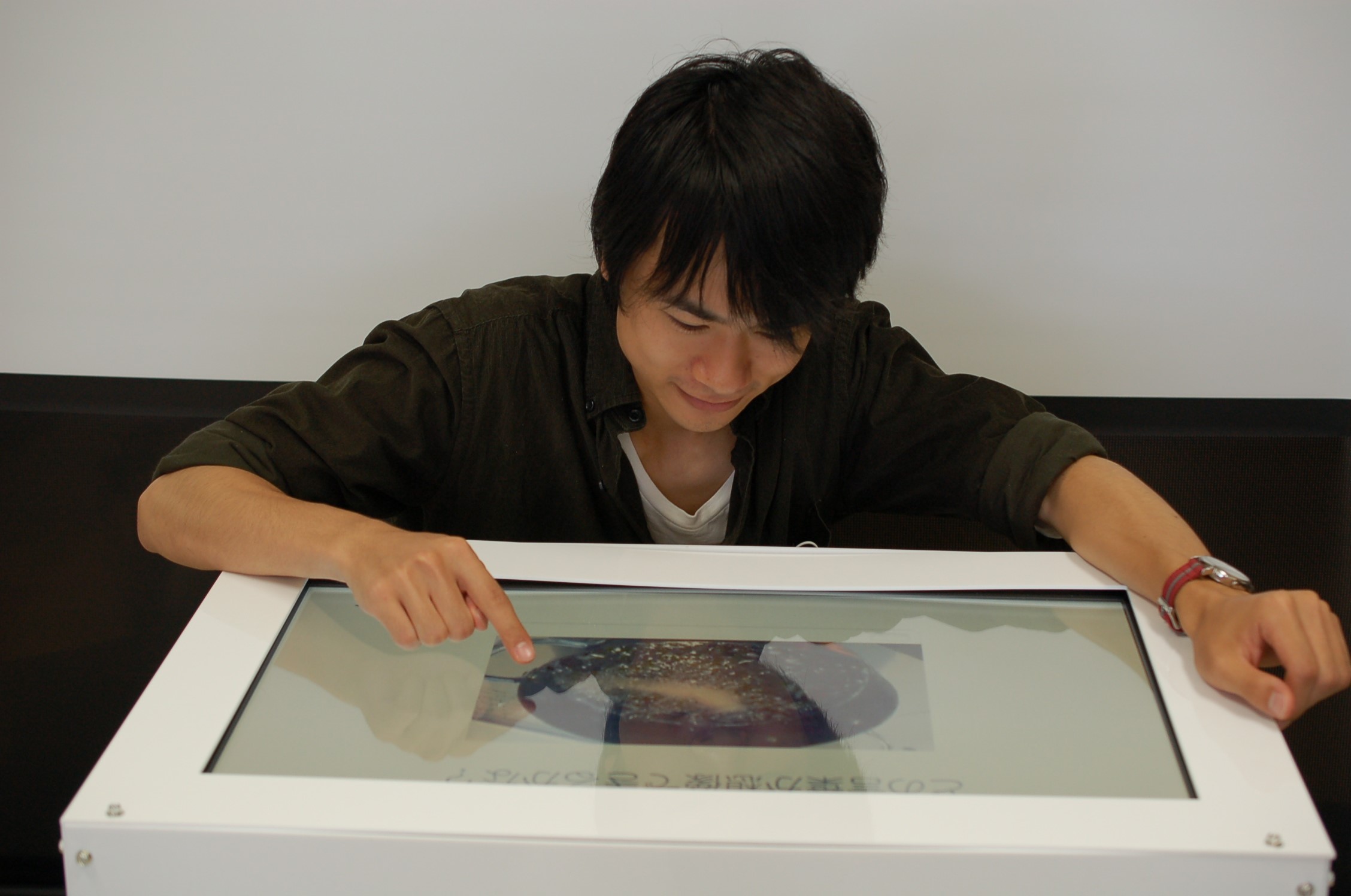

このとき、私たちの研究室では、テーブルトップディスプレイに料理を映し出し、その映像の位置から音が聞こえてくる臨場感音響提示技術を開発しました。ディスプレイの周辺にスピーカを配置するのが普通ですが、ステレオ方式で音源の方向性を感じさせることはできるものの、テーブルトップディスプレイでごく近い位置から映像を見た場合、映像の位置から音が出ているようにはなかなか聞こえません。

そこで、超音波スピーカを天井に吊るし、超音波音声をテーブルトップディスプレイのガラス面に反射させて音波を耳に届かせる方法を使いました。超音波スピーカは、超指向性スピーカとも呼ばれ、音が広がらずに直進し、ガラスなどの面で反射する特性があります。そのために画面に映っている天ぷらを揚げているその位置から、パチパチと音が聞こえてくるという演出ができました。

発話ロボット技術

人がことばを話すとき、のどにある声帯で音が作られ、顎、唇、舌などの動きによって音が調節されて言語音が発せられます。この音声言語生成の仕組みを模擬した発話ロボットを目指して、人が話すときの、唇や舌の形や動きを計測し、実物そっくりの模型を作って動かすということにチャレンジしています。

舌、唇、顎、顔面は、色々な形の多くの筋が入り交じってとても複雑な動きをします。筋は脳からの指令によって収縮することはできますが、延ばすことはできません。入り交じって配置された様々な筋の収縮のバランスだけを使って、舌を口から出したり、舌先を歯の裏にくっつけたり、人は実に多様な制御をしています。この複雑な動きの仕組みを明らかにし、人工的に模擬できるようにし、最終的には、人と同じように舌や唇を自由自在に操ってことばを話すことができるロボットを創ることが目標です。